Guide complet du Retrieval Augmented Generation (RAG)

- Clément Schneider

- 16 août

- 6 min de lecture

Dernière mise à jour : il y a 3 jours

Vous avez probablement testé ChatGPT ou un autre grand modèle de langage (LLM) comme Claude, Gemini ou LLaMA. Le résultat est souvent bluffant : reformulations fluides, créativité, structuration d’idées.Mais dès que vous lui posez une question pointue sur votre entreprise — comme "Quelles sont nos garanties produit pour un client en Suisse ?" — la magie disparaît. L’IA se met à deviner, oublie votre contexte et donne des réponses inexactes.

C’est normal. Les IA « génératives pures » apprennent d’un corpus fermé, figé au moment de l’entraînement. Elles n’ont pas accès à vos bases documentaires, à vos données produit à jour, ni à vos process internes. Elles n’ont ni mémoire, ni moteur de recherche intégré vers vos connaissances.

Le Retrieval Augmented Generation (RAG) a été inventé précisément pour lever cette barrière. C’est la technologie qui permet à une IA de retrouver l’information dont elle a besoin dans VOS données internes, puis de s’en servir pour générer une réponse contextualisée, sourcée et conforme à la réalité.

Qu’est-ce que le RAG ?

Le RAG (Retrieval Augmented Generation, que l’on peut traduire par « génération augmentée par récupération ») est une approche hybride qui associe :

Un moteur de récupération d’information : il va trouver dans une base documentaire les extraits les plus pertinents pour répondre à la question.

Un modèle de langage génératif (LLM) : il reformule ces informations en une réponse claire, naturelle et contextualisée.

On peut comparer cela à un duo :

Le bibliothécaire (« retrieval ») : il sait exactement où chercher dans vos documentations internes, FAQ, CRM, rapports PDF, etc.

L’expert (« generation ») : il lit ces documents et synthétise une réponse adaptée au ton et au contexte.

Sans le bibliothécaire, l’expert parle de mémoire, avec ses lacunes et ses approximations. Avec le RAG, il s’appuie toujours sur des données vérifiées.

Comment fonctionne concrètement le RAG ?

Le processus s’articule en quatre grandes étapes qui répondent à la question-clé que beaucoup se posent : « Comment l’IA sait-elle réellement où chercher dans mes données ? »

Étape 1 — Ingestion et vectorisation

On commence par intégrer tous vos documents pertinents : pages web, fiches produit, manuels techniques, conditions générales, historiques tickets de support, etc.Ces documents sont « découpés » en segments de taille optimale, puis convertis en vecteurs : des représentations mathématiques qui traduisent le sens du texte dans un espace multi-dimensionnel. Ces vecteurs sont stockés dans une base vectorielle comme Pinecone, Weaviate ou Milvus.

Étape 2 — Recherche sémantique (retrieval)

Lorsqu’un utilisateur pose une question, celle-ci est également convertie en vecteur. On calcule ensuite la similarité entre cette question et les segments en base pour identifier ceux qui portent le plus de sens commun avec la question, même si les mots exacts diffèrent.

Étape 3 — Augmentation

Les extraits choisis sont rassemblés et insérés dans un « super-invite » (prompt) destiné au modèle de langage :

« Voici la question de l’utilisateur et les documents qui contiennent les éléments pour y répondre. Utilise uniquement ces éléments pour répondre. »

Étape 4 — Génération finale

Le LLM (comme GPT‑4 ou Claude 3) produit une réponse fluide, cohérente et sourcée.Certaines implémentations fournissent même des liens directs vers les documents originaux, ce qui renforce la vérifiabilité — essentielle en juridique, finance, santé.

RAG vs. Prompt vs. Fine-tuning : que choisir et quand ?

Beaucoup confondent ces approches, et c’est une des premières questions que les décideurs posent.

Critère | Prompt | Fine-tuning | RAG |

But premier | Orienter la réponse de l'IA | Apprendre un style ou une structure | Injecter des données métier à jour |

Données dynamiques | ❌ | ❌ | ✅ |

Citation des sources | ❌ | ❌ | ✅ |

Mise à jour des connaissances | ❌ | ❌ (ré-entrainement nécessaire) | ✅ (mise à jour des documents) |

Complexité technique | Faible | Élevée | Moyenne à élevée |

Coût initial | Très faible | Élevé | Moyen à élevé |

En résumé :

Utilisez un prompt seul pour les tâches créatives ou internes sans données spécifiques.

Utilisez le fine-tuning pour enseigner un style ou un jargon stable.

Utilisez le RAG dès que la précision, la fraîcheur et la traçabilité des réponses sont critiques.

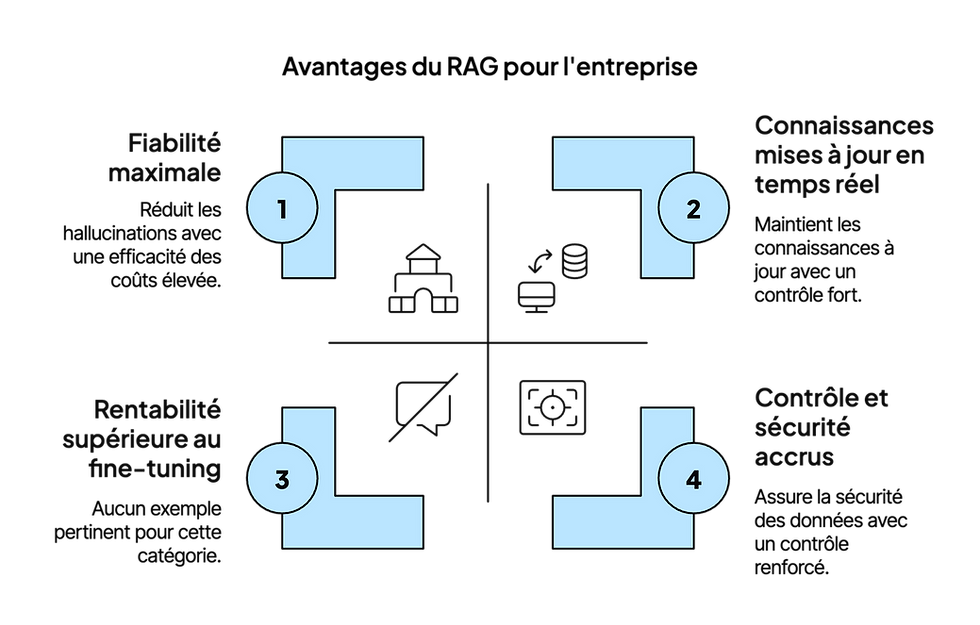

Pourquoi (et où) le RAG est un avantage stratégique

Les retours d’expérience d’entreprises ayant déployé des solutions RAG montrent qu’il s’agit de bien plus qu’une simple amélioration technique. Cette approche constitue un véritable levier de performance mesurable, avec des gains observés dans plusieurs domaines clés.

Gain de productivité sur la recherche d’information

Le RAG optimise considérablement le travail des équipes expertes et des « knowledge workers », en leur permettant de retrouver et contextualiser rapidement des données dispersées dans des bases internes ou des documents métier. Ce bénéfice est particulièrement marqué dans les recherches à forte valeur ajoutée, comme les analyses juridiques, les investigations techniques ou les échanges collaboratifs complexes.Si les données globales manquent encore, plusieurs études sectorielles rapportent des réductions de temps de recherche allant de 30 % à 60 % après mise en place du RAG, notamment sur la manipulation de documentation et d’instructions internes.

Réduction des délais de réponse en service client

L’intégration du RAG dans les chatbots, les agents virtuels et les FAQ dynamiques accélère fortement la résolution des tickets et des demandes complexes. Par exemple, un grand distributeur international a constaté une hausse de 25 % de l’engagement client grâce à des réponses et recommandations personnalisées générées par un moteur RAG.Ces résultats se traduisent non seulement par des délais de traitement raccourcis, mais aussi par une meilleure satisfaction client et par une fluidité dans le support difficilement atteignable avec un modèle de langage seul.

Amélioration de l’engagement marketing

En marketing, la force du RAG réside dans sa capacité à récupérer en temps réel les informations les plus pertinentes : catalogue produit actualisé, tendances sectorielles, historique d’un client, données de campagnes précédentes.Cette agilité permet de créer des campagnes ultra-personnalisées et réactives. Dans les entreprises qui exploitent le RAG pour la recherche de produits, la recommandation et l’automatisation des contenus, l’engagement client peut progresser jusqu’à 25 %. Ces résultats confirment une tendance observée dans l’ensemble du digital : les campagnes ciblées et data-driven surpassent systématiquement les approches génériques en taux de clics et en conversions.

Réduction des coûts opérationnels

Le RAG aide aussi à diminuer les frais d’exploitation. Il réduit notamment le besoin de réentraîner les modèles de langage, limite la consommation de ressources informatiques et fiabilise les réponses générées. Moins d’erreurs et moins « d’hallucinations » signifient moins d’interventions a posteriori pour corriger les réponses, avec une baisse notable des charges liées à ces corrections.Ces économies sont particulièrement importantes dans les secteurs à forte intensité de connaissance (juridique, informatique, relation client), où les coûts humains et logistiques liés à l’accès et à la transmission d’informations sont élevés.

Les outils pour déployer un RAG en entreprise

Voici les cinq frameworks et plateformes leaders, et le contexte idéal pour chacun :

LangChain – Le couteau suisse du RAGÉcosystème très riche, architecture modulaire, workflows complexes. Idéal pour projets sur mesure ou multi-sources.

LlamaIndex – Spécialiste de l’indexation avancéePensé RAG dès le départ, support de données multimodales, stratégies de recherche sophistiquées.

Haystack (Deepset) – L’orienté productionPipelines prêts à l’emploi, très robuste, support commercial. Parfait pour grands comptes.

RAGFlow – Clé en main visuelleInterface graphique, citations intégrées, multi-formats (PDF, Word, images). Pour déploiement rapide.

Pathway – Performance et temps réel350+ connecteurs, idéal pour ingestion continue et cas à forte volumétrie.

Vous souhaitez implémenter le RAG dans votre entreprise ? Découvrez mes solutions d'intégration IA.

Bonnes pratiques et points de vigilance

Qualité des données : un RAG ne sera jamais meilleur que vos documents source. Il faut nettoyer, dédoublonner, structurer.

Mise à jour continue : intégrer un workflow où chaque nouveau document est vectorisé et ajouté à la base.

Sécurité : appliquer des contrôles d’accès et respecter les réglementations (RGPD, HIPAA…).

Formation utilisateurs : apprendre à poser des questions efficaces et à interpréter des réponses sourcées.

Futur et tendances du RAG

L’évolution se joue autour de :

Agents RAG autonomes : non plus simples répondants, mais capables d’orchestrer des actions multi-étapes eux-mêmes.

RAG multimodal : combiner texte, image, son, données IoT.

Modèles sectoriels : spécialisation fine (santé, droit, énergie).

Architectures distribuées et fédérées : pour partager des connaissances inter-entreprises sans exposer les données brutes.

Conclusion – de la culture générale à l’expertise métier

Le RAG comble le fossé entre l’intelligence générique des LLMs et l’expertise pointue de vos équipes.En l’adoptant, vous donnez à votre IA :

Votre mémoire (en temps réel),

Une capacité à justifier ses réponses,

Une compréhension profonde de votre métier.

Les données montrent que son impact va au-delà de la simple amélioration technique : il transforme la productivité, la qualité de service et le ROI marketing.Et surtout, il donne à vos équipes le pouvoir de se concentrer sur des tâches à plus forte valeur ajoutée, en laissant l’IA traiter la recherche et la restitution d’informations exactes.

Adopter le RAG aujourd’hui, c’est préparer votre organisation à être leader dans l’économie pilotée par l’IA de demain.

Clément Schneider est consultant et partenaire d'exécution en marketing & IA, fondateur de Schneider AI et auteur best-seller du livre « Être choisi par l'IA ». Ancien CMO dans des startups de la Silicon Valley et intervenant pour des universités comme OMNES/INSEEC ou CSTU, il aide les organisations à transformer leur marketing grâce à l’IA générative, en conciliant innovation et performance business.